Anzahl Durchsuchen:1 Autor:Site Editor veröffentlichen Zeit: 2025-09-10 Herkunft:Powered

Ja, ein Server-CPU/GPU-Wasserblock kann die Überhitzung von KI-Cluster effektiv verhindern, indem sie überlegenes thermisches Management mit direkter Direkt-zu-Chip-Management liefert, das eine intensive Wärme (z. B. 385W pro Komponente) weitaus effizienter löst als Luftkühlung. Dies verhindert die thermische Drosselung, sorgt für eine anhaltende Spitzenleistung für KI-Arbeitsbelastungen und sorgt für die Systemstabilität, was für den kontinuierlichen Betrieb von AI-Clustern mit hoher Dichte von entscheidender Bedeutung ist.

Der schnelle Anstieg der künstlichen Intelligenz (KI) hat Server -CPUs - und insbesondere GPUs - auf ihre absoluten Grenzen gefahren. In dichten AI -Clustern erzeugen diese Prozessoren außergewöhnliche Wärmewerte, die häufig thermische Drosselungs- und Systeminstabilität verursachen. Traditionelle Luftkühlung kann nicht mehr Schritt halten. Um diese Herausforderungen zu bewältigen, bieten die Server -CPU/GPU -Wasserblocks eine direkte und leistungsstarke Lösung, um eine konsistente Leistung und Zuverlässigkeit selbst unter extremen Arbeitsbelastungen zu gewährleisten.

Warum stehen AI -Cluster gegenüberorten mit einzigartigen Überhitzungsherausforderungen?

Wie bekämpfen Server -CPU/GPU -Wasserblocks intensive KI -Wärmebelastungen?

Welche spezifischen Leistungsvorteile bieten Wasserblocks KI -Cluster an?

Wie verbessern Wasserblocks die Zuverlässigkeit und Langlebigkeit in KI -Umgebungen?

Welche Überlegungen sind wichtig, wenn Sie Wasserblocks für KI -Cluster implementieren?

KI -Cluster sind nicht nur Sammlungen mächtiger Server. Sie sind hochspezialisierte, dicht gepackte Rechenkraftwerke für kontinuierliche, intensive Workloads. Dieses einzigartige operative Profil schafft thermische Herausforderungen, die die von allgemeinen Rechenzentren weit übertreffen.

AI-Cluster sind aufgrund der anhaltenden Nutzung von 100% iger Nutzung von High-TDP-GPUs und CPUs, die konzentrierte Wärmebelastungen erzeugen (z. B. 700 W+ pro GPU), einzigartige Überhitzungsherausforderungen ausgesetzt sind. Ihre Konfigurationen mit hoher Dichte begrenzen den Luftstrom, wodurch herkömmliche Luftkühlung unzureichend ist, um thermische Drosselungen zu verhindern und stabile Betriebstemperaturen aufrechtzuerhalten, was zu einer Leistungsverschlechterung und der Systeminstabilität führt.

Der Kern des Überhitzungsproblems eines KI -Clusters beruht auf der Natur der KI -Arbeitsbelastungen selbst. Im Gegensatz zu typischen Serveraufgaben, die möglicherweise schwankende Lasten, KI-Schulungen, Inferenz und LLM-Verarbeitung (Language Language Model) aufweisen, erfordern häufig die Nutzung von CPUs und GPUs in der Nähe von 100% für längere Zeiträume, manchmal Tage oder Wochen. Diese anhaltende, maximale Belastung bedeutet, dass diese Komponenten ständig ihre maximale thermische Konstruktionskraft (TDP) erzeugen.

Betrachten Sie eine moderne AI -GPU wie eine Nvidia H100 oder A100, die eine TDP von 350 W bis über 700 W haben kann. Ein einzelner Server könnte neben Hochleistungs-CPUs 4 bis 8 solche GPUs unterbringen und gemeinsam Tausende von Wärme in einem sehr engen Raum erzeugen. Beispielsweise wird ein AI -Cluster, der ein komplexes Deep -Lern -Modell ausführt, jede GPU zu seinen thermischen Grenzen schiebt und eine konstante, intensive Wärmeausgabe erzeugt. Traditionelle Luftkühler, auch große, haben Schwierigkeiten, diese Art von anhaltender, konzentrierter Wärme effektiv aufzulösen, was zu einem raschen Anstieg der Komponententemperaturen führt. Genau hier wird ein Server -CPU/GPU -Wasserblock , der für die Behandlung solcher extremen Wärmebelastungen ausgelegt ist (z. B. ein 385 -W -TDP -Wasserblock), unverzichtbar.

Komponententyp | Typischer TDP-Bereich (luftgekühlt) | Typischer TDP-Bereich (flüssiggekühlt) | Überhitzungsrisiko (Luft) |

Server -CPU | 150W - 300W | 200W - 400W+ | Moderat bis hoch |

AI GPU | 300W - 700W+ | 400W - 1000W+ | Sehr hoch |

AI -Cluster sind für die maximale Rechendichte ausgelegt. Dies bedeutet, so viele leistungsstarke GPUs und CPUs wie möglich in jedes Server -Chassis zu packen und dann so viele dieser Server wie möglich in jedes Rack zu packen. Dies maximiert die Rechenleistung pro Quadratfuß, schränkt den Luftstrom stark ein und verschärft das Überhitzungsproblem.

In einem dicht gepackten GPU -Serverregal ist der Speicherplatz zwischen Komponenten und Servern minimal. Luft, selbst wenn sie von mächtigen Fans bewegt werden, kämpft darum, alle Ecken und Winkel zu durchdringen und 'Hot Spots' zu erzeugen, wo sich Wärme ansammelt. Die heiße Abgaseluft von einem Server kann zum nächsten zur Einlassluft werden, was zu einem kaskadierenden thermischen Problem führt. Zum Beispiel könnte ein 4U-Server mit 8 High-TDP-GPUs seine internen Lüfter über die Zeit arbeiten, aber das schiere Wärmevolumen überfordert die Fähigkeit der Luft, sie wegzutragen. Dies führt häufig dazu, dass die interne Temperatur des Servers steigt und die GPUs zum Herunterdrosseln zwingt.

Ein Server -CPU/GPU -Waterblock befasst sich direkt mit diesem, indem er Wärme an der Quelle entzieht, bevor er sogar den internen Luftstrom des Servers eingeben kann. Dies reduziert die Umgebungstemperatur innerhalb des Server -Chassis und des Racks erheblich, wodurch die allgemeine thermische Umgebung wesentlich mehr überschaubar wird. Aus diesem Grund ist die Flüssigkühlung für KI nicht nur eine Option, sondern eine Notwendigkeit für KI-Rechenzentren mit hoher Dichte , um weit verbreitete Überhitzungsprobleme zu verhindern.

Bei der extremen Wärme, die von einem AI -Cluster erzeugt wird , stockt die traditionelle Luftkühlung häufig. Die Server -CPU/GPU -Wasserblocks bieten einen grundlegend unterschiedlichen und weitaus effektiveren Ansatz, wodurch die überlegenen Wärmeübertragungseigenschaften von Flüssigkeiten zur direkten Bekämpfung von intensiven Wärmelasten eingesetzt werden.

Server CPU/GPU-Wasserblocks bekämpfen intensive AI-Wärmebelastungen durch Verwendung von hochleitendem Kupfer und einem optimierten internen Mikrokanal-Design, um Wärme (z. B. 385W) direkt vom Prozessor zu absorbieren und auf ein flüssiges Kühlmittel zu übertragen. Dieser direkte, effiziente Wärmeaustausch (mit R-CA von nur 0,028 ° C/w) wird die Wärme schnell aus der Komponente entfernt, wodurch die thermische Ausreißer verhindern und stabile, niedrige Betriebstemperaturen für die anhaltende KI-Leistung von entscheidender Bedeutung sind.

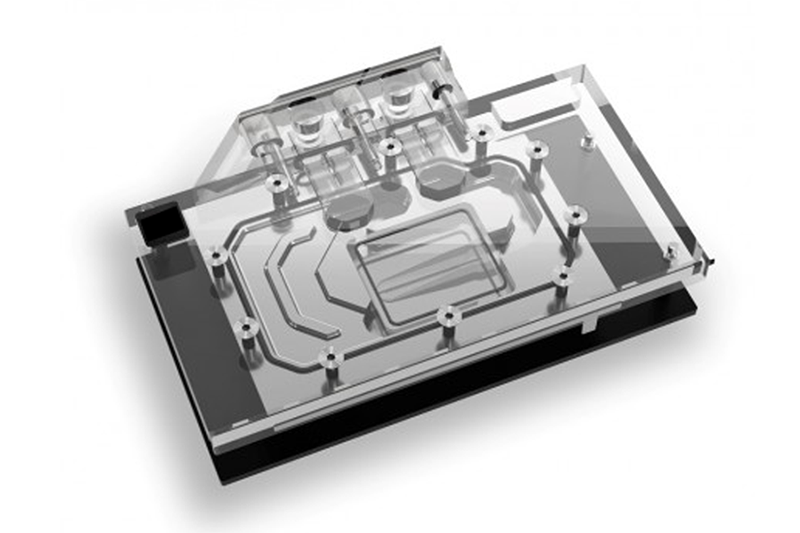

Das Kernprinzip, wie Server-CPU/GPU-Wasserblocks intensive AI-Wärmebelastungen bekämpfen, ist die direkte Wärmeentfernung. Anstatt sich auf Luft zu verlassen, um die Wärme aus einem verkleideten Kühlkörper passiv zu absorbieren, legt ein Wasserblöcke ein hochthermisch leitendes Material (typischerweise Kupfer) direkt auf den integrierten Wärmeverteiler des Prozessors (IHS). Diese Kupferbasis hat dann interne Kanäle, durch die ein flüssiges Kühlmittel fließt.

Flüssigkeit, insbesondere Kühlmittel auf Wasserbasis, weist im Vergleich zur Luft eine deutlich höhere spezifische Wärmekapazität und thermische Leitfähigkeit auf. Dies bedeutet, dass Flüssigkeit weit mehr Wärmeenergie pro Volumeneinheit aufnehmen und transportieren kann. Zum Beispiel beträgt die spezifische Wärmekapazität des Wassers ungefähr das Vierfache der Luft und seine thermische Leitfähigkeit etwa 25 -mal höher. Dies ermöglicht eine benutzerdefinierte kupferflüssige Kaltplatte , die Hitze von einer AI-GPU (z. B. 700 W+) oder einer CPU (z. B. 300 W+) schnell abzuziehen. Die Wärme wird dann von der fließenden Flüssigkeit zu einem Kühler weggetragen, der sich häufig außerhalb des Servers oder des Racks befindet, wo sie effektiver gelöst werden kann.

Diese direkte und effiziente Wärmeübertragung ist für AI -Cluster von entscheidender Bedeutung , da sie verhindert, dass Wärme an der Quelle aufgebaut wird. Beispielsweise kann ein GPU-Wasserblock , der für eine 385W-TDP-Komponente mit einem R-CA von 0,028 ° C/W ausgelegt ist, die Temperatur der GPU signifikant niedriger als ein Luftkühler, selbst unter kontinuierlichen, schweren KI-Arbeitsbelastungen. Diese direkte Entfernung bedeutet, dass die Wärme niemals in den internen Luftstrom des Servers eingeht und die allgemeine Wärmebelastung auf dem Server und das HLK -System des Rechenzentrums verringert.

Eigentum | Luft (bei STP) | Wasser (bei 25 ° C) | Nutzen für Wasserblocks |

Spezifische Wärme (j/kg · k) | ~ 1000 | ~ 4180 | Kann ~ 4x mehr Wärme pro Masse der Einheit aufnehmen. |

Wärmeleitfähigkeit (w/m · k) | ~ 0,026 | ~ 0,6 | Kann ~ 25x mehr Wärme durchführen. |

Dichte (kg/m³) | ~ 1.2 | ~ 997 | Kann mehr Wärme in einem kleineren Volumen transportieren. |

Die Effektivität von Server -CPU/GPU -Wasserblocks bei der Bekämpfung intensiver AI -Wärmebelastungen ist ebenfalls ein Beweis für die Präzisionstechnik und die fortschrittliche Herstellung. Es reicht nicht aus, einfach Kupfer und Flüssigkeit zu haben. Das Design muss jeden Aspekt der Wärmeübertragung optimieren.

Ultra-Flat-Paarungsoberfläche: Die Basis eines CPU-Wasserblocks oder GPU-Wasserblocks muss unglaublich flach und glatt sein, um einen maximalen Kontakt mit dem IHS des Prozessors zu gewährleisten. Alle mit Luft gefüllten mikroskopischen Lücken fungieren als Isolatoren, die die Leistung stark verschlechtern. Hochvorbereitete CNC-Bearbeitung, wie die von Kingka verwendet, erreicht die für die Anwendung und Wärmeübertragung optimale thermischen Grenzflächenmaterial (TIM) erforderliche Flachheit auf Mikrometerebene.

Optimierte interne Mikrokanäle: Die internen Flüssigkeitskanäle sind akribisch ausgelegt, um die Oberfläche zu maximieren, die dem Kühlmittel ausgesetzt ist und gleichzeitig die Durchflussrestriktion minimiert (Druckabfall). Diese Mikrokanäle erzeugen Turbulenz, die die Wärmeübertragung vom Kupfer auf die Flüssigkeit verbessert. Beispielsweise könnte ein Wasserblock ausgelegt sein, um seine optimale 385 -W -Ableitungen mit einer bestimmten Durchflussrate von 1,0 lpm und einem Druckabfall von 3,60 psi zu erreichen, was auf ein sorgfältig ausgewogenes Design hinweist.

Robustes Versiegelung: Angesichts der Tatsache, dass Flüssigkeit und Elektronik nicht mischen, ist die Versiegelung des Wasserblocks von größter Bedeutung. Fortgeschrittene Techniken wie Vakuum-Löcher (für Kupfer) oder Reibungsschweißen (FSW für Aluminium) sorgen.

Diese Genauigkeit stellt sicher, dass die Server -CPU/GPU -Wasserblöcke die durch KI -Arbeitsbelastung erzeugte massive Wärme konsistent und zuverlässig entfernen kann, wodurch Überhitzung verhindern und dem KI -Cluster ohne Kompromisse mit vollem Potenzial eingesetzt werden können.

Für AI -Cluster ist die Leistung von größter Bedeutung. Überhitzung verursacht nicht nur Instabilität. Es wirkt sich direkt auf die Geschwindigkeit und Effizienz des KI -Modelltrainings und der Inferenz aus. Server CPU/GPU -Wasserblocks bieten spezifische, messbare Leistungsvorteile, die für die Maximierung der Ausgabe dieser anspruchsvollen Rechensysteme von entscheidender Bedeutung sind.

Die Server -CPU/GPU -Wasserblocks bieten KI -Clustern spezifische Leistungsvorteile, indem sie thermisches Drossel verhindern, anhaltende Spitzenrandgeschwindigkeiten für GPUs und CPUs ermöglichen und eine konsequente, vorhersehbare Leistung bei intensiven KI -Arbeitslasten gewährleisten. Dies führt direkt zu einer schnelleren Modelltrainingszeiten, einem höheren Inferenzdurchsatz und maximierten Rechenausgabe, was sie für Hochleistungs-AI-Rechenzentren wesentlich macht.

Einer der wichtigsten Leistungsvorteile der Server -CPU/GPU -Wasserblocks für AI -Cluster ist die Beseitigung von Wärmedrosseln. Wenn eine CPU oder eine GPU eine vordefinierte Temperaturgrenze erreicht, reduziert sie automatisch die Taktrate und den Stromverbrauch, um Schäden zu vermeiden. Dies schützt zwar die Hardware, degradiert zwar die Leistung stark und verschwendet Rechenzyklen effektiv.

In einem KI -Cluster , der einen Tief -Lern -Trainingsjob ausführt, kann das Thermal -Drosselstunden Stunden oder sogar Tage bis zur Fertigstellung hinzufügen. Ein GPU-Server mit luftgekühlter GPUs kann stark beginnen, aber wenn die Temperaturen unter anhaltender Belastung steigen, wird der GPUs drosselt und den gesamten Trainingsprozess verlangsamt. Ein Server -CPU/GPU -Wasserblock hält dagegen durchweg niedrige Betriebstemperaturen bei, sodass die Prozessoren die gesamte Dauer der Arbeitsbelastung mit ihren maximalen Boost -Uhren laufen können.

Beispielsweise kann eine Nvidia H100 -GPU eine Basisuhr von 1,7 GHz und eine Boost -Uhr von 2,0 GHz haben. Bei der Luftkühlung kann es aufgrund thermischer Grenzen nur 1,8 GHz erhalten. Mit einem GPU-Wasserblock kann es konsistent 2,0 GHz oder höher aufrechterhalten, was zu einem signifikanten Anstieg der Gleitkommaoperationen pro Sekunde (FLOPS) führt. Dieser direkte Leistungsschub bedeutet, dass KI -Modelle schneller trainieren, die Iterationen schneller sind und Forscher schneller Ergebnisse erzielen und sich direkt auf die Effizienz und die Ausgabe des AI -Rechenzentrums auswirken können.

Kühlmethode | GPU -Taktgeschwindigkeit (anhaltende Last) | KI -Trainingszeit | Inferenzdurchsatz |

Luftkühlung | Reduziert (durch Drosselung) | Länger | Untere |

Flüssigkühlung | Max Boost Clock (konsistent) | Kürzer | Höher |

Abgesehen von nur Rohgeschwindigkeit bieten die Server -CPU/GPU -Wasserblocks den entscheidenden Vorteil einer konsistenten und vorhersehbaren Leistung für KI -Workloads. In einem AI -Cluster , in dem mehrere GPUs und CPUs parallel funktionieren, können inkonsistente Leistung auch wenige Komponenten die Synchronisation und Effizienz des gesamten Clusters stören.

Wärme Drosselung kann unvorhersehbar sein und aufgrund von Umgebungstemperaturen, Staubaufbau oder geringfügigen Unterschieden in einzelnen Komponenten -Thermik variieren. Diese Variabilität macht es schwierig, die Abschlusszeiten der Arbeitsbelastung genau zu schätzen oder sicherzustellen, dass alle Komponenten gleichermaßen zur Berechnung beitragen. Mit CPU -Wasserblocks und GPU -Wasserblocks sind die Betriebstemperaturen in allen Komponenten viel stabiler und gleichmäßiger. Diese Konsistenz sorgt dafür:

Pünktliche Workloads abgeschlossen: Die vorhersehbare Leistung ermöglicht eine genauere Planungs- und Ressourcenzuweisung innerhalb des AI -Clusters.

Optimale Ressourcenauslastung: Alle GPUs und CPUs tragen zu ihrem maximalen Potential bei und verhindern, dass Engpässe, die durch unterdurchschnittliche, drosselte Komponenten verursacht werden.

Vereinfachtes Management: IT -Mitarbeiter verbringen weniger Zeit für Fehlerbehebung thermische Probleme und mehr Zeit, um die tatsächlichen KI -Workloads zu verwalten.

In einem verteilten KI -Trainingsszenario kann beispielsweise ein GPU -Server thermisch drosseln, und kann den gesamten verteilten Trainingsprozess verlangsamen. Eine benutzerdefinierte kupferflüssige Kaltplatte stellt sicher, dass jede GPU im Cluster optimal funktioniert und zu einer effizienteren und zuverlässigeren Gesamttrainingsumgebung führt. Diese Konsistenz ist für groß angelegte KI-Operationen von unschätzbarem Wert, bei denen jede Sekunde der Rechenzeit kritisch ist.

Der intensive, kontinuierliche Betrieb von AI -Clustern legt immense Hardware und macht Zuverlässigkeit und Langlebigkeit von größter Bedeutung. Überhitzung ist ein primärer Täter für die Abbau und das Versagen der Komponenten. Bei der Server -CPU/GPU -Wasserblocks geht es nicht nur um Leistung. Sie sind eine kritische Investition in die langfristige Gesundheit und Stabilität einer AI-Infrastruktur.

Server-CPU/GPU-Wasserblocks verbessern die Zuverlässigkeit und Langlebigkeit in AI-Umgebungen, indem die konstant niedrigere und stabilere Betriebstemperaturen aufrechterhalten wird, wodurch die thermische Belastung und der Abbau von CPUs und GPUs mit hohem Wert erheblich verringert werden. Dies verhindert einen vorzeitigen Komponentenausfall, verlängert die Hardwarelebensdauer und minimiert kostspielige Ausfallzeiten, um den kontinuierlichen, zuverlässigen Betrieb zu gewährleisten, der für missionskritische KI-Workloads wesentlich ist.

Hohe Temperaturen sind der Feind elektronischer Komponenten. Eine anhaltende Exposition gegenüber erhöhten Temperaturen beschleunigt verschiedene Abbaumechanismen wie Elektromigration, Materialermüdung und chemische Reaktionen innerhalb des Halbleiters. Für teure Hochleistungskomponenten wie AI-GPUs (z. B. NVIDIA H100) und Server-CPUs (z. B. Intel Xeon) kann dies zu einem vorzeitigen Ausfall führen, wodurch die detaillierten Kapital- und Betriebskosten erhebliche Kapital- und Betriebskosten kosten.

Server -CPU/GPU -Wasserblocks mindern dieses Risiko direkt, indem sie Komponenten erheblich kühler halten als die Luftkühlung. Durch die Aufrechterhaltung der Betriebstemperaturen unter den kritischen Schwellenwerten reduzieren sie die thermische Belastung drastisch. Beispielsweise kann eine kundenspezifische kupfflüssige Kaltplatte, die für eine 385W-TDP-Komponente ausgelegt ist, ihren Temperaturanstieg auf nur 10,78 ° C über der Kühlmitteltemperatur (mit R-CA = 0,028 ° C/W) halten. Diese stabile Umgebung mit niedrigerer Temperatur:

Verlängert die Lebensdauer: Komponenten dauern länger und verzögern die Notwendigkeit kostspieliger Ersatz.

Reduziert die Ausfallraten: Weniger Komponenten scheitern unerwartet und verbessert die Gesamtsystem -Verfügbarkeit.

Pflege der Leistung im Laufe der Zeit: Komponenten behalten ihre Leistungsmerkmale für eine längere Dauer bei, wodurch ein allmählicher Abbau vermieden wird.

In einem AI -Rechenzentrum , in dem Hardware -Investitionen erheblich sind, können die Lebensdauer jedes GPU -Servers und seiner Komponenten sogar ein oder zwei Jahre zu Millionen von Dollar an Einsparungen führen. Dies macht die flüssige Kühlung für KI zu einer strategischen Investition in die langfristige Gesundheit und finanzielle Lebensfähigkeit des Clusters.

Temperaturbereich | Auswirkungen auf die Lebensdauer der Komponenten | Auswirkungen auf die Zuverlässigkeit |

Hoch (> 85 ° C) | Signifikant reduziert | Niedrig (hohe Ausfallrate) |

Moderat (65-85 ° C) | Reduziert | Mäßig |

Niedrig (<65 ° C) | Erweitert | Hoch (niedrige Ausfallrate) |

Über die Lebensdauer der einzelnen Komponenten hinaus tragen die Server -CPU/GPU -Wasserblocks zur allgemeinen Stabilität und Verfügbarkeit des gesamten AI -Cluster bei . Überhitzungsprobleme können zu:

Systemstürze/Neustarts: Wenn Komponenten kritische Temperaturen erreichen, kann das System automatisch heruntergefahren oder neu gestartet werden, um Schäden zu vermeiden und die laufenden KI -Workloads zu unterbrechen.

Unvorhersehbare Fehler: Wärmespannung kann zu intermittierenden Fehlern oder Instabilität führen, die schwer zu diagnostizieren sind, was zu Verschwendungszeit und Debugging -Bemühungen führt.

Wartungsaufwand: Häufige thermische Probleme erfordern mehr Technikerzeit für Fehlerbehebung, Reparaturen und Komponentenersatz.

Durch die Verhinderung dieser Überhitzungsszenarien sorgen die Server -CPU/GPU -Wasserblocks sicher, dass der AI -Cluster mit größerer Stabilität und Zuverlässigkeit arbeitet. Dies bedeutet, dass KI -Schulungsjobs ohne Unterbrechung abgeschlossen sind, Inferenzdienste ständig verfügbar sind und die kritische Forschung nicht verzögert ist. Für ein missionskritisches KI-Rechenzentrum ist die Minimierung der Ausfallzeiten von größter Bedeutung, da jede Stunde verlorener Berechnung in erheblichen finanziellen Verlusten oder verpassten Möglichkeiten führen kann.

Die robuste Konstruktion und die durchlaufende Versiegelung hochwertiger kunden Kaltplatten , die häufig durch fortschrittliche Herstellungsprozesse wie Vakuumlöhne oder FSW erreicht werden, sind auch für langfristige Zuverlässigkeit von entscheidender Bedeutung. Die strenge Qualitätskontrolle von Kingka, einschließlich mehrerer Lecketests und dimensionalen Inspektionen, stellt sicher, dass jeder Server -CPU/GPU -Wasserblock zur unerschütterlichen Stabilität in den anspruchsvollsten KI -Umgebungen aufgebaut ist.

Das Implementieren von Server -CPU/GPU -Wasserblocks in einem KI -Cluster ist eine strategische Entscheidung, die sorgfältige Planung und Berücksichtigung von nur den Wasserblöcken selbst erfordert. Ein ganzheitlicher Ansatz für das gesamte Flüssigkühlsystem ist unerlässlich, um die Vorteile zu maximieren und eine erfolgreiche Einsatz zu gewährleisten.

Implementieren von Server -CPU/GPU -Wasserblocks für AI -Cluster erfordert sorgfältige Berücksichtigung der gesamten Flüssigkühlschleife, einschließlich Pumpenkapazität, Kühlergrößen, Kühlmitteltyp und Leckerkennungssystemen. Die Anpassung für bestimmte Serverarchitekturen und KI -Workloads ist sowie robuste Wartungsprotokolle und Expertenentwurfsunterstützung von entscheidender Bedeutung, um eine optimale thermische Leistung, Zuverlässigkeit und nahtlose Integration in die AI -Rechenzentrumsinfrastruktur zu gewährleisten.

Ein Server -CPU/GPU -Wasserblock ist nur ein Teil eines größeren Flüssigkühlungs -Ökosystems. Seine Wirksamkeit hängt vollständig von der ordnungsgemäßen Konstruktion und Implementierung der vollständigen Flüssigkühlschleife ab. Zu den wichtigsten Überlegungen gehören:

Pumpenkapazität und Redundanz: Die Pumpe muss leistungsstark genug sein, um das Kühlmittel mit der erforderlichen Durchflussrate (z. B. 1,0 l /m pro Wasserblöcke) gegen den Gesamtdruckabfall des Systems zu zirkulieren. Für missionskritische KI-Cluster ist die Pumpe-Redundanz von wesentlicher Bedeutung, um einzelne Versagenspunkte zu verhindern.

Kühler-/CDU -Größen Sie: Der Wärmetauscher (Kühler- oder Kühlverteilungseinheit - CDU) muss ausreichend angelegt werden, um die kumulative Wärmebelastung von allen CPU -Wasserblöcken und GPU -Wasserblocks im Cluster abzuleiten. Wenn beispielsweise ein Rack 8 GPUs jeweils 700 W enthält, muss die CDU 5600 W Wärme verarbeiten.

Kühlmitteltyp und -qualität: Die Auswahl des richtigen Kühlmittels (z. B. entionisiertes Wasser mit Antikorrosionszusatzstoffen, Glykolmischungen oder Dielektrizflüssigkeiten) ist entscheidend für die Langlebigkeit und Leistung von Systemen. Eine regelmäßige Überwachung der Kühlmittelqualität ist ebenfalls wichtig.

Sanitär und Verteiler: Das Design der Schläuche, Schnelldiskonnects und Verteiler innerhalb des Servers und des Racks müssen die Durchflussrestriktion minimieren und eine gleichmäßige Kühlmittelverteilung an alle Wasserblöcke sicherstellen.

Die Erkennung und Sicherheit der Lecksexuelle: Die Implementierung robuster Leckerkennungssysteme und automatische Abschaltmechanismen ist von größter Bedeutung, um wertvolle Hardware in einem AI-Rechenzentrum zu schützen.

Die Zusammenarbeit mit einem erfahrenen Thermallösungsanbieter wie Kingka, der einen One-Stop-Service von Design bis zur Herstellung bietet, ist entscheidend für die Gestaltung einer ausgewogenen und zuverlässigen Flüssigkeitskühlschleife. Unser Fachwissen in kundenspezifischen Kaltplatten erstreckt sich darauf, zu verstehen, wie sie sich in das breitere System integrieren.

Systemkomponente | Hauptüberlegung | Auswirkungen auf KI -Cluster |

Pumpe | Durchflussrate, Kopfdruck, Redundanz. | Gewährleistet eine ausreichende Kühlmittelkreislauf, verhindert das Drossel. |

Kühler/CDU | Wärmedissipationskapazität, Lüfterkonfiguration. | Entfernt Wärme aus der Flüssigkeit, verhindert den systemweiten Anstieg der Temperatur. |

Kühlmittel | Typ, Antikorrosionseigenschaften, elektrische Leitfähigkeit. | Schützt die Komponenten, behält die thermische Leistung bei, verhindert Shorts. |

Sanitär | Material, Durchmesser, Schnelldiskonnects, Druckabfall. | Gewährleistet einen effizienten Fluss, vereinfacht die Wartung, verhindert Lecks. |

Leckerkennung | Sensoren, automatische Absperrung, Alarmsysteme. | Schützt die Hardware vor Schäden und minimiert Ausfallzeiten bei Lecks. |

Für eine optimale Leistung und Zuverlässigkeit in einem AI -Cluster ist die Anpassung häufig der Schlüssel. Während Standard -Server -CPU/GPU -Wasserblocks möglicherweise einige Anwendungen entsprechen, profitieren hochspezialisierte KI -Server häufig von benutzerdefinierten Kaltplatten, die auf ihre einzigartigen Abmessungen, Stromversorgung und thermische Profile zugeschnitten sind.

Benutzerdefiniertes Design: Eine benutzerdefinierte kupferflüssige Kaltplatte kann so ausgelegt werden, dass sie perfekt zu einem bestimmten GPU-Modul oder einem Multi-CPU-Motherboard passt, wodurch der thermische Kontakt und die Anschlussplatzierung für die nahtlose Integration optimiert wird. Die kostenlose Unterstützung für technische Entwürfe von Kingka, einschließlich thermischer Analyse und Luftstromsimulationen, trägt dazu bei, diese maßgeschneiderten Lösungen zu erstellen.

Regelmäßige Wartung: Wie jedes fortschrittliche System erfordert die Flüssigkeitskühlung regelmäßig Wartung. Dies beinhaltet die Überprüfung des Kühlmittelpegels, die Überprüfung von Lecks, die Reinigung von Kühler und das potenzielle Austausch des Kühlmittels regelmäßig. Die Einrichtung klarer Wartungsprotokolle ist für die langfristige Zuverlässigkeit von entscheidender Bedeutung.

Expertenunterstützung: Partnerschaft mit einem Hersteller, der sowohl im thermischen Management als auch in der Präzisionsherstellung (wie Kingka, mit 15 Jahren Erfahrung) über ein tiefes Fachwissen verfügt, bietet wertvolle Unterstützung. Dies beinhaltet Unterstützung bei der Entwurf, Fehlerbehebung und der Sicherstellung, dass die Server -CPU/GPU -Wasserblocks durch strenge Kontrollen hochwertigste Standards erfüllen (z. B. 4+ Inspektionen, CMM, Lecketests).

Durch die Berücksichtigung dieser Faktoren können KI -Rechenzentren erfolgreich Server -CPU/GPU -Wasserblocks implementieren, um nicht nur Überhitzungsprobleme zu verhindern, sondern auch das volle Potenzial ihrer Computerinfrastruktur auszuschöpfen, um eine anhaltende Leistung, Zuverlässigkeit und einen Wettbewerbsvorteil im sich schnell entwickelnden Feld von AI zu gewährleisten.

Die intensiven Rechenanforderungen moderner KI -Cluster stellen beeindruckende thermische Herausforderungen dar, die die traditionelle Luftkühlung nicht mehr angemessen ansprechen kann. Server -CPU/GPU -Wasserblocks werden als kritische und hochwirksame Lösung erscheint und verhindern direkt Überhitzungsprobleme, die ansonsten Leistung und Zuverlässigkeit lähmen würden. Durch die Nutzung der überlegenen Wärmeübertragungsfähigkeiten von Flüssigkeiten stellen diese präzisionsmotorierten Komponenten sicher, dass CPUs und GPUs mit hohem TDP und GPUs in ihrer anhaltenden Spitzenleistung operieren können, die frei von den Einschränkungen des thermischen Drossels.

Die Vorteile für AI -Rechenzentren sind tiefgreifend: schnelleres KI -Modelltraining, Durchsatz mit höherem Inferenz, verlängerte Hardware -Lebensdauer und erheblich verbesserte Systemstabilität. Dies führt direkt in reduzierte Betriebskosten, eine höhere Rendite für die Hardwareinvestition und eine widerstandsfähigere, zukunftssichere Infrastruktur. Während die Implementierung die gesamte Flüssigkühlschleife sorgfältig berücksichtigt und häufig von der Anpassung profitiert, machen die langfristigen Leistung, Zuverlässigkeit und Nachhaltigkeit den Server-CPU/GPU-Wasserblock zu einer unverzichtbaren Technologie für eine ernsthafte KI-Cluster.

In Kingka verstehen wir die einzigartigen und anspruchsvollen thermischen Anforderungen der KI. Mit unserer mehr als 15-jährigen Erfahrung als Anbieter von Thermallösungen One-Stop, die sich auf kundenspezifische Kupfer-Flüssigkaltplatten und Präzisions-CNC-Teile spezialisiert haben, sind wir einzigartig positioniert, um AI-Rechenzentren dabei zu helfen , ihre Überhitzungsherausforderungen zu bewältigen. Unser Expertenteam ist bereit, mit Ihnen zusammenzuarbeiten, von der ersten Design- und thermischen Analyse bis hin zur Herstellung und Lieferung, um sicherzustellen, dass Ihr KI -Cluster kühler, schneller und zuverlässig läuft.