Anzahl Durchsuchen:0 Autor:Site Editor veröffentlichen Zeit: 2025-12-24 Herkunft:Powered

KI-Arbeitslasten bringen GPUs auf extreme Hitzeniveaus, was zu Drosselung, Hardwareausfällen und stagnierenden Fortschritten beim Training großer Modelle führen kann. Die Luftkühlung hat mit dichten Clustern zu kämpfen, was Energie und Platz verschwendet und gleichzeitig die Skalierung einschränkt. Flüssigkeitsgekühlte GPU-Systeme lösen dieses Problem, indem sie Wärme direkt über das Kühlmittel absorbieren und übertragen und so dichtere Konfigurationen, einen geringeren Energieverbrauch und unterbrechungsfreies Hochleistungsrechnen für kritische KI-Aufgaben ermöglichen.

Stellen Sie sich die Skalierung eines KI-Inferenzclusters vor, um Echtzeitabfragen für Millionen von Menschen zu verarbeiten – flüssigkeitsgekühlte GPU-Systeme sorgen dafür, dass alles kühl, effizient und zuverlässig läuft und potenzielle Engpässe in reibungslose Abläufe umgewandelt werden.

Inhaltsverzeichnis

Wie bewältigen flüssigkeitsgekühlte GPU-Systeme hohe Wärmedichten?

Was macht sie für die Systemzuverlässigkeit und -verfügbarkeit unerlässlich?

Wie beschleunigen sie die KI-Trainings- und Inferenzgeschwindigkeiten?

In modernen KI-Clustern leisten GPUs wie NVIDIA H100 über 700 W pro Einheit und erzeugen so Wärmeströme, die luftbasierte Methoden in engen Rackräumen überfordern.

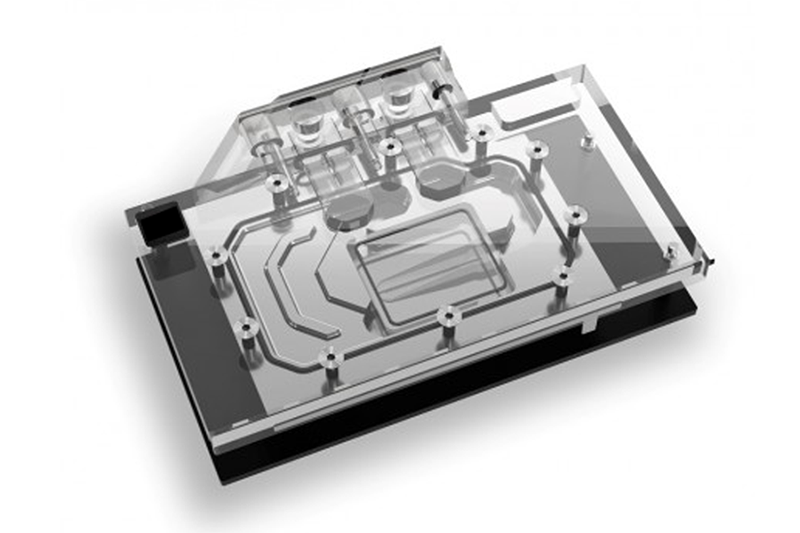

Flüssigkeitsgekühlte GPU-Systeme sind für die Bewältigung hoher Wärmedichten von entscheidender Bedeutung, indem sie das Kühlmittel direkt auf die GPU-Oberflächen zirkulieren lassen und so bis zu 1.000 W pro Modul bei gleichmäßiger Temperaturkontrolle ableiten und so Hotspots verhindern, die die Leistung in dichten 8-GPU-Servern beeinträchtigen könnten.

Dieser direkte Kontakt übertrifft die Einschränkungen der Luft in kompakten Umgebungen.

Beispiele: NVIDIAs HGX-Plattformen mit vielfältig integrierten Kühlplatten; Kundenspezifische Setups in großen KI-Supercomputern unter Verwendung von Wasser-Glykol-Mischungen für Racks mit mehr als 50 kW.

Theoretische Grundlage: Die hohe spezifische Wärmekapazität des Kühlmittels (viermal so hoch wie die von Luft) ermöglicht eine effiziente Konvektion und reduziert den Wärmewiderstand auf 0,05 °C/W. Kompromisse: Anfängliche Komplexität der Installation im Vergleich zu einer 2- bis 3-fach höheren Dichte; Reduziert Pumpenausfälle durch redundante Schleifen.

Praktische Auswirkungen: Ermöglicht 60–80 GPUs pro Rack im Vergleich zu 20–30 mit Luft, wodurch die Rechenleistung in begrenzten Rechenzentrumsflächen gesteigert wird.

Dichtemetrik | Luftkühlung | Flüssigkühlung |

Leistung pro GPU | 300-500W | 700–1000 W+ |

GPUs pro Rack | 20-30 | 60-80 |

Handhabung des Wärmeflusses | 20-30 kW/Rack | 50–100 kW/Rack |

Praktischer Rat: Überwachen Sie die Kühlmitteldurchflussraten (0,5–2 GPM pro GPU) mit Sensoren; Führen Sie während der Installation Dichtheitsprüfungen durch, um die Integrität in Konfigurationen mit hoher Dichte sicherzustellen.

KI-Training verbraucht enorm viel Strom, wobei Cluster oft mehr als 1 MW leisten, während eine ineffiziente Kühlung die Stromrechnungen und PUE-Verhältnisse in die Höhe treibt.

Flüssigkeitsgekühlte GPU-Systeme steigern die Energieeffizienz, indem sie die Wärme an der Quelle erfassen und zum Heizen der Anlage wiederverwenden. Dadurch wird der PUE-Wert auf unter 1,1 gesenkt und die Betriebskosten im Vergleich zu luftgekühlten Alternativen in großen Inferenzfarmen um 30–50 % gesenkt.

Gezielte Kühlung minimiert die Energieverschwendung des Lüfters.

Beispiele: Azure-KI-Cluster, die Kühlmittelwärme für die Erwärmung von Büros recyceln; Equinix-Rechenzentren erzielen mit Tauchkühlungsvarianten 40 % Energieeinsparungen.

Theoretische Grundlage: Der überlegene Wärmeübertragungskoeffizient der Flüssigkeit (bis zum 10-fachen der Luft) verringert den erforderlichen Luftstrom, wodurch die Hilfsenergie von 20 % auf 5 % des Gesamtstroms sinkt. Kompromisse: Höhere Vorabkosten werden durch einen ROI von 2–3 Jahren ausgeglichen; Zum Eintauchen sind kompatible dielektrische Flüssigkeiten erforderlich.

Praktische Auswirkungen: Reduziert den CO2-Fußabdruck um 20–40 % durch geringere Netzbelastung und Wärmewiederverwendung in Fernwärmesystemen.

Effizienzfaktor | Luftsystem PUE | Flüssiges System PUE |

Grundlinie | 1,5-2,0 | 1,05-1,2 |

Energieeinsparungen | Grundlinie | 30-50 % |

Potenzial zur Wärmewiederverwendung | Niedrig | Hoch |

Hinweis: Integration in kühlerlose Designs mit Umgebungskühlung; Überprüfen Sie den PUE vierteljährlich, um die Vorlauftemperaturen (20–40 °C) zu optimieren.

Die Erweiterung von KI-Clustern erfordert modulares Wachstum ohne Überholung der Anlagen, wobei die Rackleistung durch Luft auf 20–30 kW begrenzt wird.

Flüssigkeitsgekühlte GPU-Systeme erleichtern die Skalierbarkeit durch die Unterstützung von 50-100-kW-Racks und ermöglichen das nahtlose Hinzufügen von Knoten für Exascale-KI-Training ohne Erweiterung der Stellfläche, was für Hyperscaler, die Petabyte-Datensätze verarbeiten, von entscheidender Bedeutung ist.

Modulare Verteiler vereinfachen Upgrades.

Beispiele: Die flüssigkeitsgekühlten Pods von CoreWeave sind auf über 1000 GPUs skalierbar; Die Hybridsysteme von IBM für die KI-Inferenz in Unternehmen.

Theoretische Grundlage: Systeme mit geschlossenem Regelkreis sorgen über eine druckausgeglichene Verteilung für eine konstante Leistung über alle Skalen hinweg. Kompromisse: Nachrüstung der Infrastruktur versus Erleichterung auf der grünen Wiese; Skalierbare Pumpen bewältigen variable Lasten.

Praktische Auswirkungen: Beschleunigt die Bereitstellung um 50 % und ermöglicht so eine schnelle Modelliteration in dynamischen KI-Umgebungen.

Skalenparameter | Luftgrenzen | Flüssigkeit ermöglicht |

Rack-Power | 20-30 kW | 50–100 kW+ |

Cluster-Erweiterung | Langsam, raumlastig | Modular, dicht |

Bereitstellungszeit | Monate | Wochen |

Testen: Simulieren Sie den Lastausgleich mit Software; Sorgen Sie für Schnellkupplungen für eine Hot-Swap-Skalierung.

KI-Inferenz erfordert eine Verfügbarkeit von 99,999 %, aber hitzebedingte Ausfälle in luftgekühlten Setups führen zu kostspieligen Ausfallzeiten.

Flüssigkeitsgekühlte GPU-Systeme sorgen für Zuverlässigkeit, indem sie die GPU-Temperaturen unter Volllast unter 60 °C halten, die MTBF um das Zwei- bis Dreifache verlängern und Drosselungsereignisse minimieren, die Trainingszyklen in Clustern mit mehreren Knoten unterbrechen.

Eine gleichmäßige Kühlung verhindert ein thermisches Durchgehen.

Beispiele: Plattformen mit redundanten Kühlmittelwegen für Blackwell-GPUs; Die KI-Server von Dell protokollierten in Tests keine thermischen Abschaltungen.

Theoretische Grundlage: Die sofortige Wärmeabsorption stabilisiert die Verbindungen und reduziert die Elektromigration. Kompromisse: Overhead-Überwachung versus Einfachheit der Luft; Integrierte Sensoren erkennen Anomalien frühzeitig.

Praktische Auswirkungen: Erhöht die Betriebszeit auf fünf Neunen, entscheidend für Echtzeit-KI wie autonome Systeme.

Zuverlässigkeitsmetrik | Luftkühlung MTBF | Flüssiger MTBF |

GPU-Lebensdauer | 3-5 Jahre | 7-10 Jahre |

Drosselungsinzidenz | Hoch unter Last | Minimal |

Verfügbarkeitsleistung | 99,9 % | 99,999 % |

Tipp: Predictive Maintenance implementieren; Kühlmittel jährlich spülen, um Korrosion zu vermeiden.

Chips der nächsten Generation wie NVIDIA Blackwell übersteigen 1000 W und erfordern eine Kühlung, die über die Möglichkeiten der Luft hinausgeht, um eine nachhaltige Tensor-Kernleistung zu gewährleisten.

Flüssigkeitsgekühlte GPU-Systeme sind für fortschrittliche Architekturen von entscheidender Bedeutung, da sie eine präzise On-Die-Kühlung bieten, die Spitzen-FLOPS bei längerem Training aufrechterhält und komplexe neuronale Netze ohne Leistungseinbußen bewältigt.

Anpassbare Platten passen zu sich entwickelnden Designs.

Beispiele: AMD MI300X-Setups mit vakuumgelöteten Kühlplatten; kundenspezifische FSW-Platten für die Hopper-Serie in Forschungsclustern.

Theoretische Grundlage: Die Mikrokanalintegration verbessert die Grenzschichtunterbrechung für einen besseren Wärmefluss. Kompromisse: Kosten für kundenspezifische Werkzeuge im Vergleich zu Standardprodukten; unterstützt Multi-Chip-Module.

Praktische Auswirkungen: Ermöglicht ein viermal schnelleres Training für große Sprachmodelle.

GPU-Modell | Kraftabzug | Kühlbedarf |

H100 | 700W | Direkte Flüssigkeit |

Blackwell | 1000W+ | Fortgeschrittenes Eintauchen |

Tests: Benchmark-FLOPS mit Wärmebildtechnik; Optimieren Sie die Kühlmittelviskosität für neue Werkzeuge.

Laute Ventilatoren in luftgekühlten Clustern stören die Colocation und verbrauchen zusätzlichen Strom, während der Energiehunger der KI die Netze belastet.

Flüssigkeitsgekühlte GPU-Systeme reduzieren den Lärm auf ein nahezu geräuschloses Niveau, indem sie Lüfter mit hoher Drehzahl eliminieren und die Umweltbelastung durch 30–40 % geringeren Stromverbrauch verringern, was den nachhaltigen KI-Zielen in umweltfreundlichen Rechenzentren entspricht.

Passive Pumpen sorgen für einen leisen Betrieb.

Beispiele: Immersionsgekühlte KI-Farmen senken die Emissionen; Designs, die durch Effizienz 20 % CO2 einsparen.

Theoretische Grundlage: Lüfterlose Designs senken die Akustik auf unter 30 dB; Eine effiziente Wärmeabfuhr senkt den Gesamtverbrauch. Kompromisse: Flüssigkeitsentsorgung versus Nullabfall in der Luft.

Praktische Auswirkungen: Unterstützt die ESG-Konformität und reduziert Elektroschrott durch kürzere Hardware-Lebensdauern.

Aufprallbereich | Luftsystem | Flüssigkeitssystem |

Geräuschpegel | 50–70 dB | <30dB |

Kohlenstoffreduzierung | Grundlinie | 20-40 % |

Stromverbrauch | Hohe Hilfskraft | Minimal |

Hinweis: Verwenden Sie biologisch abbaubare Kühlmittel; Integration mit erneuerbaren Energien für Netto-Null-Operationen.

Thermische Grenzen bei der Luftkühlung erzwingen eine Reduzierung der Taktrate und verlangsamen die Epochenzeiten beim verteilten Training.

Flüssigkeitsgekühlte GPU-Systeme beschleunigen Prozesse, indem sie maximale Taktraten aufrechterhalten, die Trainingszeiten für Modelle wie GPT-4-Äquivalente um 20–50 % verkürzen und Echtzeit-Inferenz in Edge-KI-Clustern ermöglichen.

Durch die gleichmäßige Kühlung wird das volle Potenzial freigesetzt.

Beispiele: GPU-Server halbieren die Inferenzlatenz; Setups für die KI-Forschung mit Übertaktungsunterstützung.

Theoretische Grundlage: Niedrigere Übergänge ermöglichen höhere Spannungen ohne Instabilität. Kompromisse: Leistungsspitzen versus Durchsatzsteigerungen.

Praktische Auswirkungen: Beschleunigt die KI bei der Arzneimittelforschung um Tage.

Geschwindigkeitsmetrik | Luftgekühlte Zeit | Flüssigkeitsgekühlte Zeit |

Trainingsepoche | 10 Stunden | 5-8 Stunden |

Inferenzlatenz | 200ms | 100–150 ms |

Übertaktungspotenzial | Beschränkt | +10-20 % |

Hinweis: Für Multi-GPU mit NVLink koppeln; Profilarbeitslasten zur Feinabstimmung der Kühlkurven.

Flüssigkeitsgekühlte GPU-Systeme sind unverzichtbar, um die thermischen Hürden der KI zu überwinden und Dichte, Effizienz und Geschwindigkeit zu liefern, die Training und Inferenz vorantreiben. Mit über 15 Jahren Erfahrung als Komplettanbieter von Wärmelösungen bietet KINGKA maßgeschneiderte Flüssigkühlplatten – wie vakuumgelötete und FSW-Designs – für GPU-Cluster, unterstützt durch thermische Simulationen und präzise CNC-Fertigung. Kontaktieren Sie sales2@kingkatech.com, um eine zuverlässige Kühlung zu entwickeln, die Ihre KI-Ambitionen unterstützt.